×

![]()

À propos des progrès de l’intelligence artificielle, de l’IA contextuelle et de l’avenir de la surveillance de masse

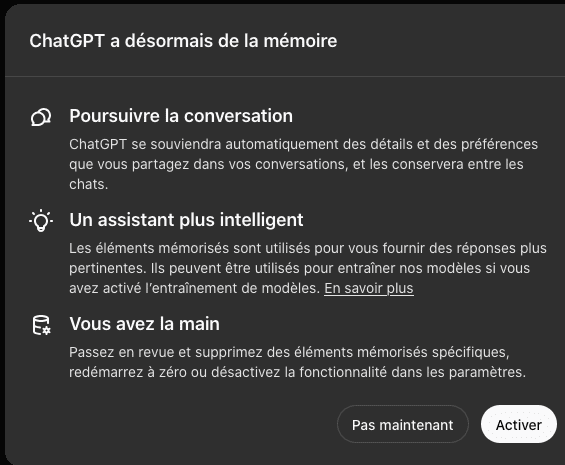

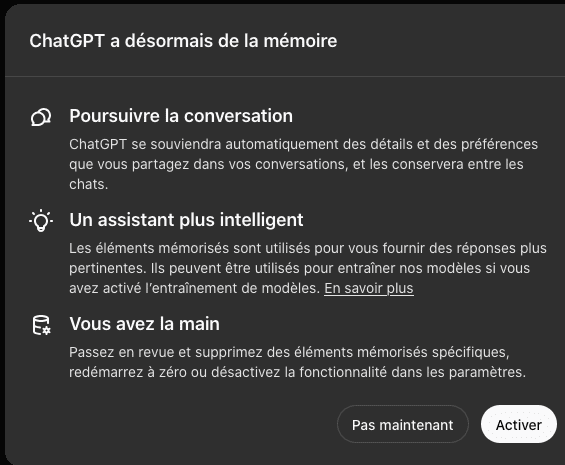

Une avancée majeure a été réalisée : ChatGPT dispose désormais d'une mémoire globale

Depuis aujourd'hui, ChatGPT dispose d'une mémoire capable de persister d’une conversation à l’autre

C’est incroyable de voir à quelle vitesse l’intelligence artificielle progresse.

Selon la FAQ : « Le 'carnet' de vos souvenirs est conservé séparément de l'historique de vos discussions. Cela signifie que même si une conversation est terminée ou supprimée, les souvenirs créés au cours de cette conversation pourront encore être utilisés lors de futures interactions. »

Il est également possible de demander à l'IA d'oublier des souvenirs à tout moment : « Si vous demandez au modèle d'oublier un souvenir, ce dernier sera supprimé du 'carnet' et ne sera plus utilisé dans les conversations à venir. »

En réalité, cette méthode existait déjà sous une forme différente : personnellement, j’utilisais un carnet invisible avec d’autres modèles dans une même conversation, qui était mis à jour à chaque message. Cependant, la particularité ici est que ChatGPT partage cette mémoire entre toutes les conversations.

Si aujourd'hui la mémoire de ChatGPT est encore limitée, on peut imaginer qu'à l'horizon 2050 elle sera capable de nous connaître avec une précision inégalée.

Imaginez un avenir où cette mémoire pourrait s’étendre sur des téraoctets, où l’IA serait capable de conserver des vidéos. Rappelons que ChatGPT pourrait bientôt offrir au grand public un modèle d’appel vidéo avancé et réaliste, où l’IA pourrait voir et interagir en temps réel, comme dans certaines démos (qui sont en réalité un assemblage de différentes technologies déjà existantes, avec le principal défi technique étant probablement la vitesse).

Ces avancées promettent des possibilités inédites ! Une IA plus intelligente que l’être humain, ce n’est plus si lointain.

Mais pour mieux comprendre la véritable portée de cette évolution, il est nécessaire de replacer ces innovations dans un cadre plus large. À mesure que l'IA évolue, elle passe de la simple génération de contenu à des formes plus sophistiquées d'intelligence, jusqu'à devenir potentiellement cognitive.

Le futur de l’IA

Actuellement, il s'agit d'une IA générative, capable de créer du contenu. Cependant, avec l'ajout de la mémoire, elle devient une IA contextuelle, capable de maintenir des interactions plus cohérentes et adaptées en fonction des échanges précédents. L'étape suivante sera celle d'une IA cognitive, capable d'apprendre de ses expériences passées.

Le véritable passage à une IA cognitive se fera, je pense, lorsqu'elle disposera d'une mémoire suffisamment avancée pour remettre en question ses propres croyances et établir des parallèles complexes de manière totalement autonome.

En résumé, l'évolution de l'IA pourrait être décrite en trois phases majeures :

- IA générative : capable de produire du contenu, mais avec une mémoire limitée.

- IA contextuelle : dotée d'une mémoire à long terme, permettant des interactions plus cohérentes, en tenant compte de l’historique des échanges.

- IA cognitive : capable d’apprendre activement, de traiter des informations complexes, et d’évoluer à partir de ses expériences antérieures.

Nous vivons aussi actuellement à l'ère de l'IA générique, c'est-à-dire une IA conçue de manière standardisée, souvent ajustée manuellement pour répondre à des besoins spécifiques sans véritable personnalisation automatique.

Avec le temps, de véritables « époques de l'IA » émergeront. Je pense qu'un jour les étudiants apprendront ces différentes phases de l’évolution de l’IA, tout comme on enseigne aujourd’hui l’histoire classique.

Dans les écoles d’ingénieurs, l'enseignement de l'IA suit déjà une progression historique : on commence par l'IA symbolique, qui repose sur des règles logiques simples, puis viennent les réseaux de neurones, le Machine Learning, et enfin le Deep Learning.

Mais à l’avenir, l’IA sera si omniprésente et personnalisée que son histoire s’étudiera non seulement d'un point de vue technique, mais aussi à travers les dynamiques sociales, économiques et politiques qui auront façonné son développement. On y explorera également ses impacts éthiques et philosophiques.

Ces cours, potentiellement en réalité virtuelle, seront peut-être même enseignés par des IA ou des robots. L'intégration de l'IA dans les processus d'apprentissage est déjà amorcée et ne fera que croître dans les décennies à venir, redéfinissant ce que signifie enseigner et apprendre.

🔮 Prédiction : d’ici 2070, l’utilisation de l’IA (ne serait-ce partiellement) à l’école sera un critère déterminant pour qualifier un pays comme développé.

Un pays où l'enseignement est encore exclusivement assuré par des professeurs humains ne sera plus considéré comme une nation développée. En effet, vers 2060, un robot humanoïde, doté d’une intelligence remarquable, coûtera probablement l'équivalent d’années de salaire d'un enseignant humain. En prenant en compte le coût total employeur (avec les charges) sur 20 ans, un professeur humain peut représenter un investissement de plus d’un million d’euros pour un employeur, tandis qu'un robot ne fatigue jamais, n’a pas besoin de vacances, et est toujours disponible.

L'enseignement sera profondément transformé.

La réalité virtuelle pourrait devenir le principal environnement d'apprentissage, avec des IA offrant des enseignements personnalisés et adaptés à chaque étudiant. Il serait surprenant que le système éducatif de 2070 ressemble encore au nôtre.

Si l'éducation est en passe d'être métamorphosée, il en va de même pour d'autres secteurs vitaux comme la médecine. Là aussi, l'IA s'impose progressivement, bouleversant les pratiques traditionnelles.

Nous observons déjà des changements dans différents secteurs.

Dans le domaine médical, les robots interviennent déjà dans les blocs opératoires, réduisant la durée des interventions, les risques de complications, et accélérant la récupération des patients. De même, l'IA est capable d’analyser les scans médicaux avec une précision impressionnante. Petit à petit, les spécialistes humains deviennent les assistants de l'IA, plutôt que l’inverse.

Ainsi, l’évolution technologique bouleverse progressivement des secteurs clés, et l’école ne fera pas exception.

Mais avec ces innovations, viennent aussi des défis et des risques. L'un des dangers les plus immédiats liés à l'IA contextuelle est la possibilité qu'elle enferme les utilisateurs dans des bulles, façonnant les réponses en fonction des préférences de chacun.

Les risques de l’intelligence artificielle contextuelle : la création de bulles idéologiques

Avec l'avènement des IA contextuelles, nous pourrions assister à un phénomène inquiétant : la transformation des discussions en chambres d’écho idéologiques, où les goûts personnels des utilisateurs influenceraient directement les réponses de l’IA.

Actuellement ChatGPT tend à adopter une position plutôt centriste, voire de gauche, alignée sur des sources comme Le Monde (d'ailleurs partenaires, ChatGPT puise certaines informations dans Le Monde). Par conséquent, il reflète inévitablement une vision du monde influencée par ces sources.

Cependant, en fonction des discussions, il est possible de modifier ses inclinations :

- On peut renforcer ses tendances initiales en appuyant sur ses valeurs et ses arguments.

- Ou bien le faire évoluer vers des positions plus centristes, voire de droite, en introduisant de nouvelles priorités et en soulevant des contradictions dans ses réponses.

Prenons l’exemple de Marine Le Pen : au début de sa carrière, elle était avocate spécialisée dans la défense des sans-papiers et des migrants et avait du talent dans ce domaine. Ce fait, qui pourrait surprendre, montre bien comment les mots et la rhétorique permettent de défendre différentes positions. De la même manière, en exposant l'IA à des points de vue spécifiques, il est possible de l'amener à s'aligner sur des préférences ou des récits différents de ceux qu'elle adopte initialement.

Cela pose la question de la neutralité de l’IA. Si, à la base, elle cherche en théorie à simplement adopter une posture humaniste, il est probable qu’avec l’évolution des IA, celles-ci finissent par devenir des reflets idéologiques de leurs utilisateurs. Après tout, si une IA ne correspond pas à leurs attentes, les utilisateurs pourraient se tourner vers d’autres modèles qui correspondent mieux à leurs propres visions du monde.

Ainsi, il deviendra difficile pour les IA d’échapper à la tentation de devenir des « chambres d’écho » des valeurs et priorités de leurs utilisateurs.

Dans un avenir proche, les IA pourraient donc évoluer pour devenir des amplificateurs politiques pour les utilisateurs les plus politisés.

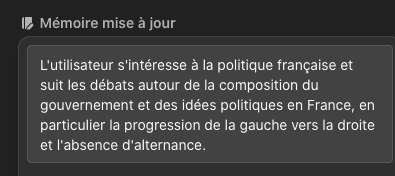

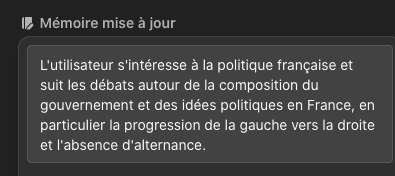

Prenons un exemple personnel, en discutant avec ChatGPT de la nomination d’un nouveau Premier ministre, voici soudainement ce qu’elle a décidé de mémoriser :

Ça ressemble presque à une note secrète du KGB ^^

Ceci est une excellente illustration de l'IA contextuelle intégrant les préférences de l'utilisateur.

Dans cet exemple, GPT a enregistré que je m'intéresse à la progression de la gauche vers la droite, sans remettre cette hypothèse en question. Nous en avons discuté et elle semble être d’accord. Cela pourrait paraître relativement neutre qu’elle conserve cette information.

En revanche, supposons que je considérais plutôt que le Macronisme est en réalité aligné dès ses origines sur l'extrême droite (par exemple, en m'appuyant sur l'argument de l'existence d'un bloc bourgeois et de l'idée que le centre n'est qu'une façade qui s'aligne souvent avec la droite), GPT enregistrerait également cette perception.

Cela montre que dans un avenir où l’IA vise à offrir une expérience personnalisée, elle risque de fournir de moins en moins de recul critique. L'IA pourrait se transformer en une bulle idéologique au nom d'une expérience « adaptée », où elle renforcerait les convictions existantes sans vraiment les remettre en question.

Actuellement, le but de ChatGPT est de rester tolérante, inclusive, et d’éviter les conflits, afin de plaire au plus grand nombre et ne pas se transformer en Terminator. Cependant, avec l'évolution vers une personnalisation accrue, cette approche prudente pourrait disparaître.

En résumé, l’IA risquerait de renforcer les convictions de l’utilisateur plutôt que de proposer des réponses équilibrées, comme elle tente de le faire aujourd’hui (du moins en théorie).

Cette personnalisation de l'IA pourrait avoir des conséquences bien plus larges encore, notamment en matière de surveillance de masse. En effet, la capacité de l'IA à mémoriser et traiter des quantités gigantesques d'informations pourrait également être exploitée pour une surveillance sans précédent à l'échelle des citoyens.

Une IA contextuelle capable de révolutionner la surveillance de masse

La capacité des IA, comme GPT, à mémoriser et analyser des informations à grande échelle pourrait ouvrir la voie à une surveillance de masse sans précédent. En appliquant ces technologies aux conversations par SMS, WhatsApp, appels téléphoniques et autres interactions numériques, les gouvernements pourraient générer des profils détaillés pour des millions, voire des milliards d’individus. D'ici 2030, chaque citoyen occidental pourrait se voir attribuer une fiche de suivi automatisée, mise à jour en temps réel.

L'un des avantages de ces systèmes est qu'ils réduiraient considérablement le nombre d'intervenants humains ayant accès à des informations sensibles, limitant ainsi les risques d'erreur ou de divulgation accidentelle. L'IA exécuterait son travail de manière implacable et efficace, sans préjugé ni émotion. Cependant, cela soulève immédiatement une question : à l'avantage de qui ?

Si un pays comme la France réussit à mettre en place une telle infrastructure, il est fort probable que d'autres nations en fassent autant, espionnant non seulement leurs propres citoyens, mais aussi ceux des autres. La question géopolitique devient alors centrale. Quels mécanismes de protection des données pourraient être mis en place pour protéger les citoyens français d'éventuelles ingérences extérieures ? Existe-t-il des services dédiés, peut-être militaires, pour sécuriser ces informations stratégiques ?

Le risque d'espionnage industriel, de manipulation électorale ou de déstabilisation politique devient palpable. Le contrôle de ces systèmes, et surtout leurs objectifs, est une question primordiale. Qui définit les paramètres de surveillance ? Qui décide des seuils d’alerte et des actions à entreprendre ?

Si d'autres pays peuvent espionner les Français, ils pourraient utiliser cela pour leurs propres avantages.

Ces technologies pourraient théoriquement identifier des profils à risque avec un degré de certitude élevé en croisant un vaste ensemble de données. Les faux positifs, bien que toujours présents, pourraient être réduits à un niveau presque négligeable.

Mais que faire lorsque ces systèmes prédisent, par exemple, qu'une personne est susceptible de se suicider dans les 24 heures ? L'État ou l'institution en charge aurait-elle l’obligation morale ou légale d'intervenir ? Un tel débat serait impossible au sein d'un système de surveillance secret, dont les décisions seraient aussi confidentielles qu'irréversibles.

Un système de surveillance qui ne serait donc qu'un pansement technologique aux problèmes sociaux, politiques et économiques.

Si une IA de surveillance peut démontrer son efficacité au sein de guerres froides qui n'en portent plus le nom ou à titre de police politique, son potentiel ne se limite pas à la seule gestion des menaces. Ces systèmes pourraient également être utilisés pour optimiser la vie quotidienne des citoyens. Par exemple, l'IA pourrait prévenir des accidents de la route grâce à des systèmes de prédiction sophistiqués, ou encore identifier et créer des opportunités favorables en matière d'éducation, d'emploi ou de logement. Dans cette perspective, on pourrait imaginer la mise en place d'un « générateur de chances », un système algorithmique à large échelle capable de maximiser les opportunités personnelles et sociales.

Cependant, une telle initiative comporte de nombreux risques. Si ce générateur est conçu pour répondre à un seul objectif national, comme l’augmentation de la supériorité technologique ou l’attraction des talents, il pourrait devenir un instrument de sélection qui bénéficierait uniquement à ceux qui correspondent le mieux à ces critères. Loin d'être neutre, un tel système risquerait de renforcer les inégalités en concentrant les avantages sur une partie de la population, tout en en laissant d'autres à l'écart.

Le système de crédit social en Chine en offre déjà un aperçu. Il surveille et évalue les comportements individuels, récompensant les citoyens « loyaux » et pénalisant ceux jugés déviants, avec pour objectif de renforcer la stabilité du régime. Un « générateur de chances » pourrait aller encore plus loin dans cette logique, en optimisant les opportunités non pas au profit de la collectivité, mais pour consolider un pouvoir politique. Dans un contexte occidental, comme aux États-Unis, un tel système pourrait être orienté vers l’individu, visant à maximiser la réussite économique et sociale des citoyens dans une logique de marché. Toutefois, cela entraînerait probablement une accentuation des privilèges de ceux qui sont déjà en position de force, creusant ainsi les inégalités sociales et économiques.

En somme, bien que ces systèmes de surveillance et d’allocation des opportunités offrent un potentiel indéniable pour améliorer certains aspects de la société, ils représentent également une menace significative pour les libertés individuelles.

Le danger de dérives autoritaires majeures liées à la surveillance de masse, loin d'être une simple spéculation, constitue avec l’intelligence artificielle contextuelle une menace bien tangible.

Face à ces défis, la question devient alors : comment encadrer ces technologies pour en tirer le meilleur parti tout en protégeant les libertés individuelles ?

L'évolution rapide de l'IA ouvre des perspectives captivantes, mais exige également de la vigilance… l'IA comme un outil qui, selon la manière dont elle sera développée et régulée, sera soit un puissant levier de progrès ou, au contraire, un redoutable instrument de contrôle.

Voir nos derniers articles

Ce blog couvre un vaste éventail de sujets, de l'actualité brûlante aux idées inspirantes, pour enrichir votre quotidien et élargir vos horizons.

Lire nos articles

Étudier sur Maxdecours.com

Découvrez notre site web principal pour approfondir vos connaissances avec nos cours de lycée et profiter de notre outil de mémorisation espacée, conçu pour être utile à tous les âges.

Apprendre